| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | ||||

| 4 | 5 | 6 | 7 | 8 | 9 | 10 |

| 11 | 12 | 13 | 14 | 15 | 16 | 17 |

| 18 | 19 | 20 | 21 | 22 | 23 | 24 |

| 25 | 26 | 27 | 28 | 29 | 30 | 31 |

- 파이썬

- SQL

- 데이터분석준전문가

- 시각화

- tableau

- Deep Learning Specialization

- 이코테

- 이것이 코딩테스트다

- 데이터 전처리

- scikit learn

- 데이터 분석

- 태블로

- 자격증

- ADsP

- 머신러닝

- r

- Python

- matplotlib

- pandas

- 코딩테스트

- IRIS

- 데이터분석

- pytorch

- SQLD

- 회귀분석

- 딥러닝

- sklearn

- 통계

- ML

- Google ML Bootcamp

- Today

- Total

목록머신러닝 (18)

함께하는 데이터 분석

[빅데이터분석기사] 빅분기 필기 합격 후기

[빅데이터분석기사] 빅분기 필기 합격 후기

오늘은 빅데이터분석기사 필기 합격 후기를 작성하려고 합니다 이번학기가 4학년 1학기여서 빅분기 필기 응시자격을 받았는데요 빅데이터분석기사는 이번 4월 8일 시험이 6회로 오래되진 않은 시험입니다 그래서 시험에 대한 정보가 생각보다 적어 어떤 책으로 해야 되는지 기간을 얼마나 잡아야 하는지 몰랐습니다 그러던 와중 기업은행 인턴할 당시 옆 인턴이 2022년 빅분기 수제비 책을 줘서 그것으로 준비했습니다 그럼 어떤 시험인지 조금 더 알아볼게요! 빅분기 목차 1. 빅데이터 분석 기획 2. 빅데이터 탐색 3. 빅데이터 모델링 4. 빅데이터 결과 해석 이렇게 이루어져 있는데 우선 1단원인 빅데이터 분석 기획은 쌩 암기단원입니다 ADsP를 준비하셨으면 조금 수월하실 것 같아요 2단원인 빅데이터 탐색은 통계학과를 전공..

[ML] CatBoost

[ML] CatBoost

CatBoost CatBoost는 많은 범주형 변수로 이루어진 데이터셋에서 성능이 매우 우수하여 categorical boost라고도 불립니다 특히 CatBoost는 다른 boosting 기반 알고리즘과 달리 categorical feature를 특별하게 처리합니다 One-Hot Encoding이나 Label Encoding 등 인코딩 과정 없이 그대로 모델에 적합시킬 수 있습니다 또 categorical feature를 그대로 모델에 넣어주면 Ordered Target Encoding을 진행합니다 Target Encoding에서 발생할 수 있는 data leakage 문제를 해결하기 위해 과거의 데이터를 이용하여 현재의 데이터를 인코딩하는 원리입니다 부스팅을 할 때 일반적인 Boosting이 아닌 Or..

[ML] XGBoost

[ML] XGBoost

XGBoost XGBoost는 "eXtreme Gradient Boosting"에서 따온 이름입니다 XGBoost는 Gradient Boosting 방법 중 하나로 많은 장점이 존재합니다 장점 효율성, 유연성이 뛰어남 overfitting 방지 가능(과적합 규제) 신경망 모델에 비해 시각화와 직관적인 이해가 쉬움 cross validation을 지원 높은 성능을 나타내어 kaggle, dacon에 많이 사용 early stopping(조기종료) 기능이 있음 missing value를 내부적으로 처리 단점 하이퍼파라미터 수가 너무 많음 XGBoost는 앞선 LightGBM 포스팅에서 본 것과 같이 level-wise로 수평적으로 확장됩니다 Python 실습 import numpy as np import w..

[ML] LightGBM

[ML] LightGBM

LightGBM LightGBM은 Gradient Boosting Machine에서 Light를 추가한 것입니다 Light가 붙은 만큼 속도도 빠르고 큰 사이즈의 데이터를 다룰 수 있고 실행시킬 때 적은 메모리를 차지합니다 추가로 LightGBM은 GPU 학습을 지원하고 결과의 정확도에 초점을 맞추므로 인기 있는 모델입니다 LightGBM은 기본적으로 GBM의 학습방식의 틀린 부분에 가중치를 주며 진행하는 방식입니다 GBM에 대한 소개는 이전 포스팅을 참고하세요 2023.01.15 - [데이터분석 공부/ML | DL] - [ML] Gradient Boosting Machine [ML] Gradient Boosting Machine Gradient Boosting Machine Gradient Boosti..

[Python] 파이토치(Pytorch) 설치하기

[Python] 파이토치(Pytorch) 설치하기

Pytorch란? 파이토치는 2017년 초에 공개된 딥러닝 프레임워크로 GPU를 활용하여 인공 신경망 모델을 만들고 학습시킬 수 있게 도와줌 Numpy라이브러리에 비해 계산이 간단하고 병렬 연산에서 GPU를 사용하므로 CPU보다 속도면에서 월등히 빠름 유명한 딥러닝 프레임워크인 텐서플로(tensorflow)는 'Define and Run' 방식으로 연산 그래프를 먼저 만들고 실제 연산할 때 값을 전달하여 결과를 얻고 파이토치(Pytorch)는 'Define by Run' 방식으로 연산 그래프를 정의하는 것과 동시에 값도 초기화되어 연산이 이루어지고 연산 속도도 빠르고, 적어도 밀리지는 않음 Pytorch 설치하기 https://pytorch.org/ PyTorch An open source machine..

[Scikit Learn] PCA

[Scikit Learn] PCA

주성분 분석(Principal Component Analysis) 차원을 축소하는 알고리즘 중 가장 인기 있는 알고리즘 사이킷런 import numpy as np np.random.seed(4) m = 60 w1, w2 = 0.1, 0.3 noise = 0.1 angles = np.random.rand(m) * 3 * np.pi / 2 - 0.5 X = np.empty((m, 3)) X[:, 0] = np.cos(angles) + np.sin(angles)/2 + noise * np.random.randn(m) / 2 X[:, 1] = np.sin(angles) * 0.7 + noise * np.random.randn(m) / 2 X[:, 2] = X[:, 0] * w1 + X[:, 1] * w2 + n..

[Scikit Learn] Random Forest

[Scikit Learn] Random Forest

랜덤 포레스트(Random Forest) 배깅 방식을 적용한 의사결정 나무(Decision Tree)의 앙상블 따라서 사이킷런의 BaggingClassifier에 DecisionTreeClassifier를 넣어 만들거나 RandomForestClassifier를 사용 사이킷런 from sklearn.model_selection import train_test_split from sklearn.datasets import make_moons X, y = make_moons(n_samples=500, noise=0.3, random_state=42) X_train, X_test, y_train, y_test = train_test_split(X, y, random_state=42) 사이킷런의 moons 데이..

[Find-A][Scikit Learn] 앙상블 학습

[Find-A][Scikit Learn] 앙상블 학습

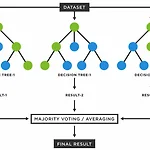

앙상블 학습 가장 좋은 모델 하나보다 비슷한 일련의 예측기로부터 예측을 수집하여 더 좋은 예측을 얻는 것 투표 기반 분류기 정확도가 80% 정도 되는 분류기를 여러 개 훈련시켰다고 가정 더 좋은 분류기를 만드는 매우 간단한 방법은 각 분류기의 예측을 모아 가장 많이 선택된 클래스를 예측 이렇게 다수결의 투표 즉, 통계적 최빈값으로 정해지는 분류기를 직접 투표(hard voting)이라 함 이 다수결 투표 분류기가 앙상블에 포함된 개별 분류기 중 가장 뛰어난 것보다 정확도가 높은 경우가 많음 각 분류기가 약한 학습기(weak learner)일지라도 많고 다양하면 앙상블은 강한 학습기(strong learner)가 될 수 있음 큰 수의 법칙 import numpy as np import pandas as p..

[Find-A][Scikit Learn] Decision Tree

[Find-A][Scikit Learn] Decision Tree

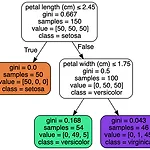

의사결정 나무(Decision Tree) 분류와 회귀 작업, 다중출력 작업도 가능한 다재다능한 머신러닝 알고리즘 최근에 자주 사용되는 강력한 머신러닝 알고리즘 중 하나인 랜덤 포레스트의 기본 구성 요소 1. 의사결정 나무 학습과 시각화 from sklearn.datasets import load_iris from sklearn.tree import DecisionTreeClassifier iris = load_iris() X = iris['data'][:, (2, 3)] y = iris['target'] 사이킷런의 iris 데이터를 불러오고 X에 PetalLength, PetalWidth y에 꽃의 품종인 Setona, Versicolor, Virginica를 할당 tree_clf = DecisionTr..

[Find-A] [Scikit Learn] 소프트맥스 회귀

[Find-A] [Scikit Learn] 소프트맥스 회귀

이번에는 소프트맥스 회귀를 진짜 맛만 보겠습니다. 정말 간단하게 저번에 봤던 iris 데이터를 가지고 코드만 돌려보는 식으로 진행할게요! 이전의 데이터 설명이나 로지스틱 회귀를 파이썬으로 돌린 포스팅은 2022.08.19 - [학회 세션/파인드 알파] - [Find - A] [Python] 로지스틱 회귀 [Find - A] [Python] 로지스틱 회귀 안녕하세요! 오늘은 로지스틱 회귀모형을 Python으로 돌려보겠습니다. 다른 포스팅에도 개념은 설명되어 있어 간단하게 말하고 넘어갈게요. 로지스틱 회귀는 이진 분류기로 샘플이 특정 클래스 tnqkrdmssjan.tistory.com 여기를 확인하시면 됩니다. 시작할게요! 소프트맥스 회귀 로지스틱 회귀 모델은 여러 개의 이진 분류기를 훈련시켜 연결하지 않고..