| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | 6 | 7 |

| 8 | 9 | 10 | 11 | 12 | 13 | 14 |

| 15 | 16 | 17 | 18 | 19 | 20 | 21 |

| 22 | 23 | 24 | 25 | 26 | 27 | 28 |

| 29 | 30 |

- IRIS

- ML

- 시각화

- r

- scikit learn

- tableau

- SQL

- 머신러닝

- 코딩테스트

- sklearn

- 회귀분석

- 파이썬

- ADsP

- Google ML Bootcamp

- 자격증

- pandas

- 태블로

- Python

- SQLD

- 데이터분석

- Deep Learning Specialization

- 이코테

- matplotlib

- 데이터 전처리

- pytorch

- 데이터 분석

- 통계

- 이것이 코딩테스트다

- 딥러닝

- 데이터분석준전문가

- Today

- Total

목록Cross validation (3)

함께하는 데이터 분석

[ML] XGBoost

[ML] XGBoost

XGBoost XGBoost는 "eXtreme Gradient Boosting"에서 따온 이름입니다 XGBoost는 Gradient Boosting 방법 중 하나로 많은 장점이 존재합니다 장점 효율성, 유연성이 뛰어남 overfitting 방지 가능(과적합 규제) 신경망 모델에 비해 시각화와 직관적인 이해가 쉬움 cross validation을 지원 높은 성능을 나타내어 kaggle, dacon에 많이 사용 early stopping(조기종료) 기능이 있음 missing value를 내부적으로 처리 단점 하이퍼파라미터 수가 너무 많음 XGBoost는 앞선 LightGBM 포스팅에서 본 것과 같이 level-wise로 수평적으로 확장됩니다 Python 실습 import numpy as np import w..

[ML] Gradient Boosting Machine

[ML] Gradient Boosting Machine

Gradient Boosting Machine Gradient Boosting Machine, GBM은 이름에서도 알다시피 Boosting 알고리즘입니다 앙상블과 부스팅에 관한 설명은 이전 포스팅을 참고해 주세요 2022.08.19 - [데이터분석 공부/ML | DL] - [Ensemble] 머신러닝 앙상블 기법 [Ensemble] 머신러닝 앙상블 기법 오늘은 머신러닝에서 자주 등장하는 앙상블 기법에 대해 알아볼게요! 우선 앙상블(Ensemble)이란 여러 개의 분류기를 생성하여 예측값을 종합하여 보다 정확한 예측값을 구하고 각각의 분류기를 tnqkrdmssjan.tistory.com GBM을 알기 위해서는 AdaBoost에 대해서도 알아야 하는데 AdaBoost는 오류 데이터에 가중치를 부여하면서 부스..

[ML] 교차검증과 하이퍼파라미터 튜닝

[ML] 교차검증과 하이퍼파라미터 튜닝

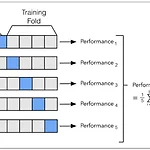

교차검증과 하이퍼파라미터 튜닝은 머신러닝 모델의 성능을 높이기 위해 사용하는 기법 교차검증 학습과 검증을 위해 train set, validation set, test set으로 데이터를 나눔 하지만 이러한 방법은 overfitting에 취약할 수 있고 데이터의 개수가 적을 때 어려움이 있음 그리고 고정된 train set와 test set으로 평가를 하다 보면 test set에서만 최적의 성능을 발휘하도록 편향될 수 있기에 이 문제를 해결하기 위해 나온 것이 교차검증 raw 데이터가 충분하지 않을 때 사용하는 방법이 k-fold cross validation 가장 보편적으로 사용되는 교차검증 기법으로 train set를 k개로 분할하여 1개의 validation fold를 나머지 k-1개의 traini..